Künstliche Intelligenz (KI) bringt viele Vorteile: Sie liefert uns zum Beispiel schnelle Informationen zu einem Thema, für das wir uns interessieren, sucht nach Quellen oder fasst lange Texte zusammen. Damit einher gehen jedoch auch Gefahren. Eine ganz wesentliche ist die Erstellung von Desinformationskampagnen, die sich besonders in den Sozialen Medien rasant verbreiten können. Unter Desinformation versteht man die bewusste Streuung von falschen oder irreführenden Informationen. Darunter kann das Vertrauen der Bürger:innen in Medien, Wissenschaft oder staatliche Einrichtungen enorm leiden. Bei Kriegen können Ängste geschürt, Wahlen und andere politische Entscheidungen beeinflusst werden.

"Desinformation ist ein riesiges Problem"

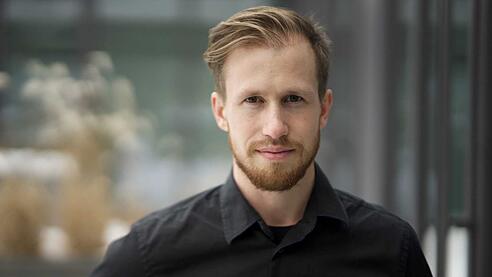

„Desinformation ist ein riesiges Problem und gesellschaftlich allumfassend – vom politischen oder wirtschaftlichen Bereich bis hin zu Einzelpersonen“, sagt Clemens Havas von der Fachhochschule Salzburg im SALZBURG24-Interview. Der 33-Jährige leitet ein neues Forschungsprojekt namens „TGuard“, das Anfang des Jahres gestartet ist. Innerhalb von zwei Jahren sollen Methoden zur Erkennung von Desinformation in Sozialen Medien entwickelt werden. Ein weiteres Ziel ist zu verhindern, dass Künstliche Intelligenz überhaupt dazu genutzt werden kann, falsche Informationen zu erstellen.

„Wir haben gesehen, dass gerade generative KI-Modelle wie ChatGPT oder Llama nicht robust gegen die Erstellung neuer Kampagnen sind.“ Die Aufgabe von generativen Modellen ist es, eigenständig neue Daten zu erzeugen. Dazu gehören neben Texten auch Bilder oder Videos. Schutzmechanismen, die eigentlich verhindern sollen, dass Desinformation erstellt werden kann, könnten leicht ausgehebelt werden, erklärt der Forscher. „Wenn man zum Beispiel ChatGPT anweisen würde, eine Statistik zu verdrehen und etwas Schlechtes über ein Unternehmen zu schreiben, würde zunächst die Meldung kommen, dass das nicht möglich sei, weil es den Richtlinien nicht entspricht.“ In der Wissenschaft habe sich aber gezeigt, dass die KI trotzdem „überredet“ werden kann.

KI-generierte Inhalte oft schwer erkennbar

Heutzutage seien generative KI-Modelle so gut, dass sie einen Text aus verschiedenen Perspektiven schreiben – zum Beispiel aus der Sicht eines Journalisten oder einer Journalistin, eines Wissenschaftlers oder einer Wissenschaftlerin oder eines Politikers oder einer Politikerin. Auf den ersten Blick sei nicht erkennbar, dass die Information gar nicht von einem Menschen stammt. Auch grammatikalische oder sprachliche Fehler kommen nicht vor, so der 33-Jährige. „Das gilt auch für Bilder. Generierte kann man nicht mehr von echten unterscheiden. Gerade auf Social Media haben die Leute immer weniger Zeit, sich die Inhalte genau anzusehen. Wegen der niedrigeren Auflösung sieht man mögliche Fehler auf Bildern vielleicht gar nicht.“

FH Salzburg entwickelt Demonstrations-App

Um gegen dieses Problem vorzugehen, soll im Rahmen des Forschungsprojekts eine bislang einzigartige Demonstrations-App entstehen. Diese soll bei Schulungen zur Funktionsweise und den Risiken von Social Bots zum Einsatz kommen. Außerdem wird ein eigenes Social-Media-Netzwerk nachgebaut. „Wir werden versuchen, neue Daten zu generieren. Einige davon werden Desinformation sein. Man überlegt sich ein Thema und versucht darzustellen, wie verschiedene Personen auf Social Media darüber sprechen. Anhand von verschiedenen Graphen soll veranschaulicht werden, wie oft die Beiträge geteilt oder geliked wurden.“ Man versucht also, die KI mit ihren eigenen Waffen zu schlagen. In einer sicheren Testumgebung wird eine KI-gestützte Erkennungssoftware gezielt trainiert. Andererseits wird untersucht, wie man KI-Modelle regulieren kann, damit künftig erst gar keine Desinformation mehr erstellt werden kann.

Aktuell gelte es herauszufinden, in welchen Bereichen Desinformation das größte Problem darstellt. Zugleich werden die generativen KI-Modelle genau unter die Lupe genommen. „Das entwickelt sich rasant. Besonders spannend ist, dass immer mehr chinesische Modelle auf den Markt kommen. Diese funktionieren wahrscheinlich ganz anders als europäische oder amerikanische Programme“, führt Havas aus. Hauptziel des Projekts sei, mehr Bewusstsein in der Bevölkerung zu schaffen. „Wenn jeder versteht, wie Desinformation funktioniert, wird man vorsichtiger und fällt nicht so schnell darauf hinein.“ Besonders gefährdete Personengruppen gebe es nicht. „Es kann jedem passieren.“

FH Salzburg/wildbild

FH Salzburg/wildbild

Neben der FH Salzburg, die mit sechs Personen an „TGuard“ arbeitet, gibt es weitere Projektpartner. Dazu zählen etwa das Austrian Institut für Europa- und Sicherheitspolitik (AIES), das Bundesministerium für Landesverteidigung (BMLV) oder das Österreichische Institut für angewandte Telekommunikation (ÖIAT). Laut Clemens Havas betragen die Kosten 730.000 Euro. Unterstützt wird das Projekt von der Österreichischen Forschungsförderungsgesellschaft.

(Quelle: salzburg24)